con

intuitivamente se dice

modelo de la fuente de información discreta sin memoria (``discrete memoryless source'')

la fuente genera una secuencia de símbolos independientes sacados

del conjunto ![]() según la distribución

según la distribución ![]()

una secuencia de tal tipo se suele llamer mensaje

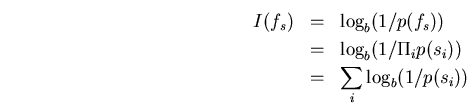

la contribución de información ![]() de un símbolo se puede determinar

como

de un símbolo se puede determinar

como

la basis ![]() del logaritmo refleja la unidad en la cual se mide la

información y influye como un factor constante

del logaritmo refleja la unidad en la cual se mide la

información y influye como un factor constante

si para dos símbolos ![]() y

y ![]() tenemos

tenemos ![]() ,

podemos derivar

,

podemos derivar

para

![]() siendo una secuencia de símbolos

independientes se calcula la probabilidad que fue emitido de la fuente

como

siendo una secuencia de símbolos

independientes se calcula la probabilidad que fue emitido de la fuente

como

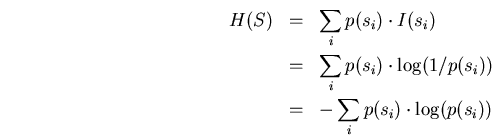

bajo la entropía ![]() de la fuente se entiende la contribución media

de información que emite la fuente por símbolo, es decir,

de la fuente se entiende la contribución media

de información que emite la fuente por símbolo, es decir,

el contenido de información que puede emitir una fuente está cotado hacía arriba por la entropía de la fuente

reducir el número de símbolos eliminando redundancia pero transmitiendo la misma cantidad de información es el objetivo de la compresión

(sin embargo, es imposible llegar al óptimo con un algoritmo general, porque dicho intento resultaría en calcular la complejidad de Kolmogoroff de una codificación de un mensaje que a su vez es una función no computable)